参考答案:

【问题1】(9分) (1)0

(1)主要包含以下三种网络:

1、以太网:前端的用户通信网络。

2、FC光纤网络:后台存储网络光纤的通道。

3、高性能计算Infiniband网络(服务器集群网络):后端做数据更新或者做集群计算的通讯网络。

(2)最多需要8块网卡与之相连。如使用trill(多链接透明互联)后,该网络无需存在。(实际服务器需与4个网络相连,每个网络需要两块网卡,故需要8块),随着TRILL技术出现,专用网络不需要。

(3)随着数据中心的不断扩大,将带来以下困难:

1、每个服务器要多个专用适配器(网卡),要不同的布线系统。

2、机房要支持更多设备:空间、耗电、制冷。

3、多套网络无法统一管理,不同的维护人员。

4、部署/配置/管理/运维困难。

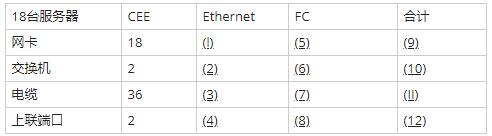

(2)0

(3)0

(4)0

(5)0

(6)0

(7)0

(8)4

(9)18

(10)2

(11)36

(12)6

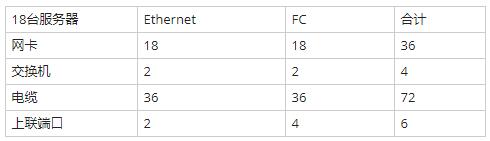

详细解析:

【问题1】(9分)1、前端用户通信网络-以太网网络;后台光纤存储网络:FC光纤网络;后端做数据更新或者做集群计算的通讯网络:高性能计算Infiniband网络(服务器集群网络)。

InfiniBand技术将会被应用于服务器与服务器(比如复制,分布式工作等),服务器和存储设备(比如SAN和直接存储附件)以及服务器和网络之间(比如LAN,WANs和the Internet)的通信。设计InfiniBand的目的主要是用于企业数据中心,大型的或小型的。目标主要是实现高的可靠性、可用性、可扩展性和高的性能。InfiniBand可以在相对短的距离内提供高带宽、低延迟的传输,而且在单个或多个互联网络中支持冗余的I/O通道,因此能保持数据中心在局部故障时仍能运转。

2、题目问的是最多需要几块网卡,为提高网络的可靠性,服务器连接前端、存储、集群计算、虚拟机迁移都采用双网卡的方式,因此一台服务器最多需要八块网卡。

随着TRILL等技术的出现,这个专用网络不需要:网络设备虚拟化构建的大二层网络不需要像传统的二层网络采用STP来破环,但是各网络设备厂商采用的网络设备虚拟化技术都是私有技术,相互之间不兼容。而TRILL是IETF推出的技术,各厂商都认同,该技术核心思想与三层网络数据转发原理一样,到一个目的地有多条路径会通过计算选择到目的地最优的路径,在二层网络中不需要采用生成树破环,因此现有的专用网络在TRILL中根本就不需要。

目前构建大二层数据中心还有IT厂商提出来的VXLAN(VMWARE)与微软提出来的NVGRE技术,微软及其他IT厂商提出该技术解决大二层网络技术中虚拟机的迁移不再依赖网络设备厂商的技术。但是该技术实现起来比较复杂。

目前还有一种技术可以实现构建跨大二层网络的数据,也就是用在大二层网络数据中心之间的技术EVLAN,采用MP-BGP来实现MAC地址信息的交互。

3、(1)每个服务器要多个专用适配器(网卡),要不同的布线系统;

(2)机房要支持更多设备:空间、耗电、制冷;

(3)多套网络无法统一管理,不同的维护人员;

(4)部署/配置/管理/运维困难。

【问题2】(4分)

FCOE技术实现了用以太网帧来承载FC帧,当帧到达目的地时再拆封装,将FC帧交给SAN网络来处理,实现了以太网与存储网络的融合(光纤存储和以太网共享同一个端口)。该技术需要服务器用专门的CAN网卡来处理以太网帧与FC帧,同时也需要专业来处理FCOE帧的FCF交换机。

1、每个服务器只需要一个专用适配器(网卡),一套布线(以太网)系统(以前需要多个网卡,多套布线(以太网和光纤)系统)。

2、机房不再要支持更多设备:空间、耗电、制冷,更加节能绿色。

只有一套网络,统一管理维护简单(原来是多套网络无法统一管理,不同的维护人员维护困难)。

3、部署/配置/管理/运维简单。

4、网卡、交换机、光纤需要的数量减半,投资减少50%,能耗及维护费用极大降低。

【问题3】(6分)

一个CNA的适配卡可以同时传输以太网和FC帧,因此一台服务器不再需要专门用来传输以太网数据的适配卡与专门用来传输FC帧的HBA适配卡,所以表(1),(5)填0,合计18块网卡。FCOE网络中的交换机也能同时支持处理以太网帧与FC帧。因此不需要专门处理以太网帧的交换机与专业处理FC帧的交换机,交换机合计为2。融合型增强以太网(CEE)电缆36根。一个CAN网卡有两个接口,采用双上行的方式连接两个CEE网络的交换机。18块卡,36个接口,因此CEE网络需要36根电缆。同样不需要电缆再接以太网和存储网络。

上联端口:FCOE的技术改造只是针对接入层网络,上行还是和原来一样,原来网络是怎么连还是怎么连,CEE已有2个上连端口连以太网,那么还是需要四个端口来连存储网络的FC交换机。

【问题4】(6分)

1、现在任何行业都讲究绿色环保,网络也不例外。所谓的PUE值是数据中心总设备能耗/IT设备能耗,基准值是2,该值越接近1表明能效水平越好。

2、即‘面对面,背靠背’设计。这样设计可更有效提高冷却效率,让冷空气与热空气走不同的通道,不让冷热风混在一起,提高制冷效果。

3、让外面的冷空气进入数据中心,不需要像空调一样还需要制冷环节,让冷空气经过数据中心带走热量,并将热量送到出风口。